Kas ir lineārā regresija? Definīcija, piemēri un pielietojumi

Uzzini, kas ir lineārā regresija — definīcija, skaidri piemēri un praktiski pielietojumi prognozēšanā, datu analīzē un modelēšanā.

Lineārā regresija ir statistikas metode, kas apraksta atkarīgā mainīgā un viena vai vairāku paskaidrojošo mainīgo attiecības, izmantojot taisnu līniju vai tā ģeneralizāciju. Tā ir īpašs regresijas analīzes gadījums, kur modeļa izteiksme ir lineāra attiecībā uz nezināmajiem parametriem.

Kā darbojas lineārā regresija

Vienkāršākajā gadījumā (vienkāršā lineārā regresija) modelis ir:

y = β0 + β1·x + ε,

kur β0 ir brīvkstens (intercepts), β1 – slīpums (koeficients), un ε – nejaušā kļūda (atlikums). Mērķis ir atrast tādas β vērtības, kas vislabāk atbilst novērotajiem datiem.

Matemātiskā pieeja un aplēse

Visbiežāk izmantotā aplēses metode ir vismazāko kvadrātu (OLS – ordinary least squares), kur minimizē atlieku kvadrātu summu. Tas nozīmē, ka modelis tiek pielāgots tā, lai vertikālie attālumi starp datu punktiem un paredzētās līnijas vērtībām būtu pēc iespējas mazi. Tomēr pastāv arī citas pieejas, piemēram:

- minimizēt absolūtās novirzes (mazāko absolūto noviržu regresija),

- regulārās versijas, kas sodu pievieno koeficientu lielumam (piem., ridge vai lasso),

- robustas metodes, kas mazāk jūtīgas pret ārkārtīgiem novērojumiem.

Ja vēlaties saglabāt konkrētus terminus no iepriekšējā teksta, piemēram, saistību ar regresijas analīzi, var atzīmēt, ka tieši lineārie modeļi bija vieni no pirmajiem rūpīgāk izpētītajiem modeļiem, jo tie ir vienkāršāki aprēķinos un analītiski izpētāmi.

Praktiskais pielietojums

Lineārā regresija tiek plaši izmantota divos galvenajos nolūkos:

- Lineārās regresijas var izmantot, lai novērojamo vērtību (datu) kopumam piemērotu prognozēšanas modeli. Tas ir noderīgi, ja mērķis ir prognozēšana, paredzēšana vai samazināšana. Ja pēc šāda modeļa izveides tiek dota papildu X vērtība, bet tai netiek pievienota y vērtība, tad piemēroto modeli var izmantot, lai prognozētu y vērtību.

- Ja ir mainīgais y un vairāki mainīgie X1, ..., Xp, kas var būt saistīti ar y, var izmantot lineāro regresijas analīzi, lai kvantitatīvi noteiktu saiknes stiprumu starp y un Xj, novērtētu, kuriem Xj vispār nav saistības ar y, un noteiktu, kuras Xj apakšgrupas satur lieku informāciju par y.

Piemēri: mājokļa cenu prognozēšana pēc kvadrātmetriem, atrašanās vietas un istabu skaita; darbinieku atalgojuma modelēšana pēc izglītības un pieredzes; bioloģisko procesu modelēšana, lai noteiktu ārējo faktoru ietekmi.

Pieņēmumi un diagnostika

Lineārajā regresijā parasti pieņem:

- lineāru attiecību starp mainīgajiem,

- atlikušu (ε) neatkarību (nav autokorelācijas),

- konstantu varianci (homoskedastiskumu),

- attiecināmu normālu sadalījumu atlikumiem (lai veiktu standarttestus),

- nav augstas multikolineraritātes starp paskaidrojošiem mainīgajiem.

Diagnostikas soļi: pārbaudīt atlikumus (residuals) vizuāli — atlikumu grafiki pret paredzētajām vērtībām, QQ-plots; testēt heteroskedastiskumu (piem., Breusch–Pagan tests), autokorelāciju (Durbin–Watson) un multikolineraritāti (VIF). Ja pieņēmumi netiek izpildīti, var izmantot transformācijas (logaritmēšana), robustas standarta kļūdas, svarotus modeļus vai alternatīvas metodes.

Interpretācija un svarīgi rādītāji

Ko nozīmē koeficienti? Vienkāršā gadījumā β1 apraksta paredzamo y izmaiņu, ja x palielinās par vienu vienību (pieņemot citus mainīgos nemainīgus). Kopējā skaidrojošā spēja tiek mērīta ar R2 (R kvadrāts) — proporcionāli skaidrotajai dispersijai, un ar koriģēto (adjusted) R2, kas ņem vērā mainīgo skaitu modelī. Statistiskā nozīmība tiek pārbaudīta, izmantojot t-testus atsevišķiem koeficientiem un F-testu visam modelim.

Vairāku mainīgo un kategorisko mainīgo izmantošana

Multiple regresija iedalās, ja ir vairāki paskaidrojošie mainīgie. Kategoriskos mainīgos (piem., dzimums, reģions) parasti iekodē kā dummy mainīgos (0/1). Jāuzmanās ar interakcijām — bieži mainīgo mijiedarbības ietveršana palīdz uzlabot modeļa atbilstību un interpretāciju.

Regulārisācija un modernākas metodes

Ja mainīgo ir daudz vai pastāv pārāk liela variāciju sajaukšana, izmanto regulārās metodes:

- Ridge regresija (L2 sods) samazina koeficientu lielumus, mazinot pārmērīgas adaptācijas risku;

- Lasso (L1 sods) var vienlaikus veikt mainīgo atlasi, nolīdzinot dažu koeficientu uz nulli;

- Elastīgā tīkla (elastic net) pieeja apvieno L1 un L2 sodus.

Tāpat modelu izvērtēšanai lieto šķērsvalidāciju (cross-validation), lai izvēlētos vispārīgāko un stabilāko modeli.

Praktiskās darbības, veidojot regresijas modeli

- Exploratīva datu analīze: grafiki, korelācijas, trūkstošo vērtību pārbaude;

- Modeļa konstrukcija: izvēlēties mainīgos, iekļaut nepieciešamās transformācijas un interakcijas;

- Aplēse: piemērot OLS vai citus algoritmus;

- Diagnostika: pārbaudīt pieņēmumus un atlikumu uzvedību;

- Uzlabojumi: regulārisācija, mainīgo atlase, transformācijas;

- Validācija: novērtēt modeļa spēju prognozēt uz jauniem datiem (testa dati vai cross-validation);

- Interpretācija un komunikācija: skaidri ziņot par koeficientiem, nepārliecinātību (konfidences intervāli) un modeļa ierobežojumiem.

Secinājums

Lineārā regresija ir spēcīgs un intuitīvs rīks gan prognozēšanai, gan ietekmes kvantificēšanai. Pareizi lietots, tas sniedz viegli interpretējamus rezultātus. Tomēr būtiski saprast pieņēmumus, veikt diagnostiku un, nepieciešamības gadījumā, izmantot regulārisāciju vai citas modernākas metodes, lai nodrošinātu uzticamus secinājumus.

Papildus var pievērst uzmanību tam, ka lineārie modeļi centīsies minimizēt atlieku kvadrātu summu — tas ir plaši izmantots princips (piem., mazāko kvadrātu), taču ir arī citi pielāgošanas veidi un sodītas versijas, kā minēts iepriekš. Dažos gadījumos lietderīgi ir minimizēt citus kritērijus, piemēram, mazāko absolūto noviržu normu (normā (kā mazāko absolūto noviržu regresijā) vai sodītas mazāko kvadrātu zaudējumu funkcijas.

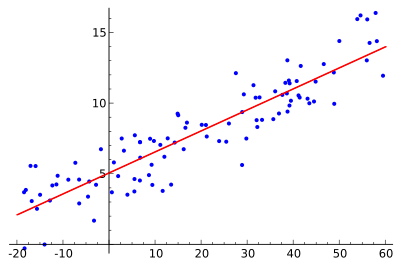

Ideja ir atrast sarkano līkni, bet zilie punkti ir faktiskie paraugi. Izmantojot lineāro regresiju, visus punktus var savienot, izmantojot vienu taisnu līniju. Šajā piemērā izmantota vienkārša lineārā regresija, kur attāluma kvadrāts starp sarkano līniju un katru parauga punktu tiek samazināts līdz minimumam.

Lietošana

Ekonomika

Lineārā regresija ir galvenais analītiskais instruments ekonomikā. Piemēram, to izmanto, lai uzminētu patēriņa izdevumus, ieguldījumus pamatlīdzekļos, ieguldījumus krājumos, valsts eksporta pirkumus, importa izdevumus, pieprasījumu pēc likvīdiem aktīviem, darbaspēka pieprasījumu un darbaspēka piedāvājumu.

Jautājumi un atbildes

J: Kas ir lineārā regresija?

A: Lineārā regresija ir veids, kā, izmantojot matemātiku, aplūkot, kā kaut kas mainās, kad mainās citas lietas. Tā izmanto atkarīgo mainīgo un vienu vai vairākus skaidrojošos mainīgos, lai izveidotu taisnu līniju, ko sauc par "regresijas līniju".

Kādas ir lineārās regresijas priekšrocības?

A: Modeļus, kas ir lineāri atkarīgi no saviem nezināmajiem parametriem, ir vieglāk piemērot nekā modeļus, kas nav lineāri saistīti ar saviem parametriem. Turklāt ir vieglāk noteikt iegūto aplēšu statistiskās īpašības.

K: Kādi ir daži lineārās regresijas praktiskie pielietojumi?

A: Lineāro regresiju var izmantot, lai piemērotu prognozēšanas modeli novērotajām vērtībām (datiem), lai veiktu prognozes, paredzējumus vai samazinājumus. To var izmantot arī, lai kvantitatīvi noteiktu attiecību stiprumu starp mainīgajiem lielumiem un identificētu datu apakškopas, kas satur lieku informāciju par citu mainīgo.

J: Kā ar lineārās regresijas modeļiem cenšas samazināt kļūdas?

A: Lineārās regresijas modeļi cenšas panākt, lai vertikālais attālums starp līniju un datu punktiem (atlikumi) būtu pēc iespējas mazāks. To dara, minimizējot vai nu atlieku kvadrātu summu (mazāko kvadrātu), vai neatbilstību kādai citai normai (mazāko absolūto noviržu), vai arī minimizējot mazāko kvadrātu zudumu funkcijas sodīto versiju (ridge regression).

Vai ir iespējams, ka lineārās regresijas modeļi nav balstīti uz mazāko kvadrātu metodi?

Jā, ir iespējams, ka lineārās regresijas modeļi nav balstīti uz mazākajiem kvadrātiem, bet tā vietā tiek izmantotas tādas metodes kā neatbilstības minimizēšana kādā citā normā (mazākā absolūtā novirze) vai mazāko kvadrātu zaudējumu funkcijas (ridge regresijas) penalizētās versijas minimizēšana.

Vai "lineārais modelis" un "vismazāko kvadrātu" ir sinonīmi?

A: Nē, tie nav sinonīmi. Lai gan tie ir cieši saistīti, "lineārais modelis" attiecas tieši uz taisnas līnijas izmantošanu, bet "vismazākie kvadrāti" attiecas tieši uz kļūdu minimizēšanu, pārliecinoties, ka starp līniju un datu punktiem ir minimāls vertikālais attālums.

Meklēt